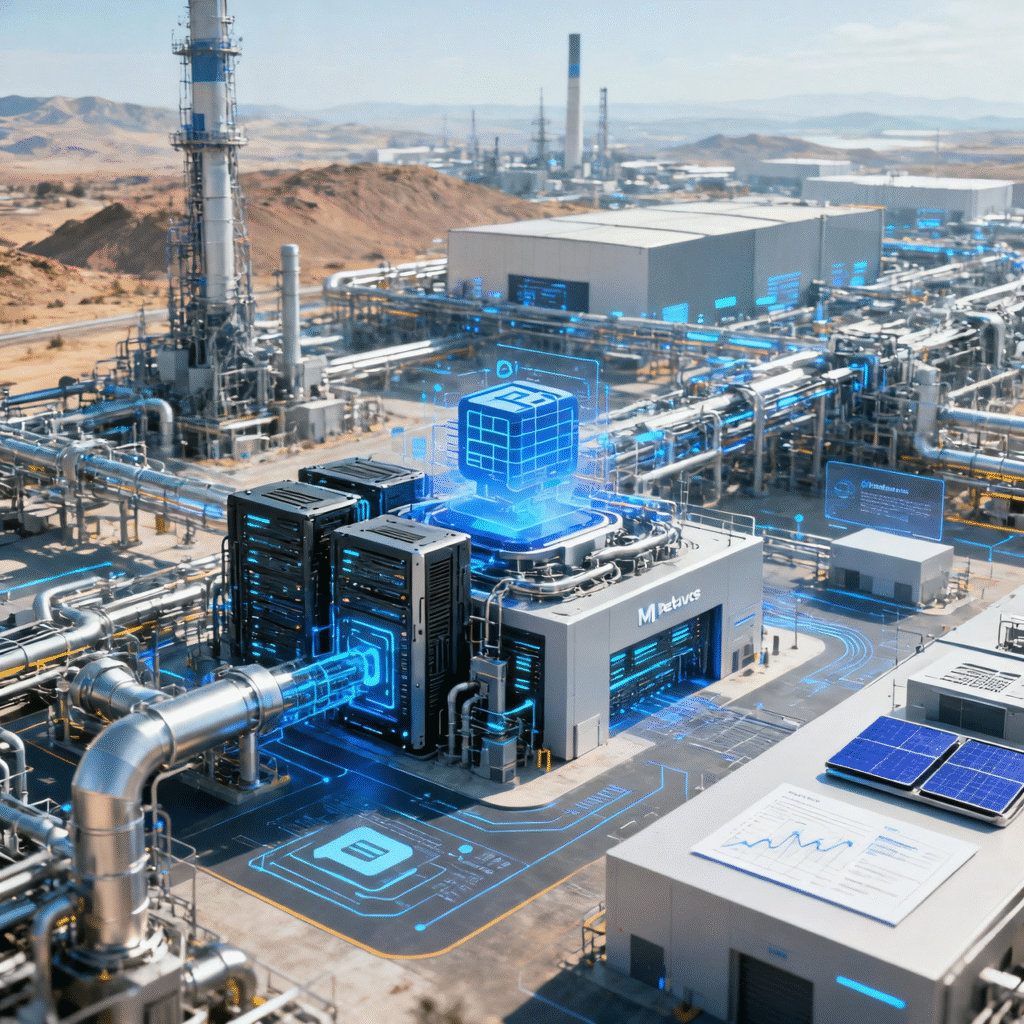

Pelatihan model Machine Learning (ML) di era Big Data telah melampaui kemampuan single server. Ketika berhadapan dengan dataset yang mencapai skala Petabyte (PB)—ribuan TeraByte—tantangan infrastruktur berubah secara drastis. Proses mendesain infrastruktur ML skala Petabyte adalah kunci keberhasilan, berpindah dari masalah komputasi sederhana menjadi persoalan manajemen I/O, latensi jaringan, dan optimalisasi biaya. Infrastruktur yang dirancang untuk beban kerja PB harus mampu menangani penyimpanan masif, menyediakan daya komputasi paralel yang ekstrem, dan memastikan pipeline data yang sangat efisien. Artikel ini mengupas strategi dan pilar utama dalam upaya mendesain infrastruktur ML skala Petabyte yang scalable. Tantangan Kunci dalam Pelatihan ML Berskala Petabyte Dataset berskala PB menghadirkan tiga tantangan fundamental bagi setiap upaya mendesain infrastruktur ML skala Petabyte: 1. Bottleneck I/O dan Latensi Jaringan Pada skala ini, waktu yang dihabiskan untuk memindahkan data dari penyimpanan ke unit pemrosesan (GPU/TPU) dapat mendominasi total waktu pelatihan. Jaringan dan sistem penyimpanan tradisional sering kali tidak mampu memberikan throughput yang diperlukan untuk menjaga GPU tetap sibuk (GPU starvation). 2. Koordinasi dan Fault Tolerance Proses pelatihan dapat berlangsung selama berhari-hari atau bahkan berminggu-minggu, melibatkan ratusan hingga ribuan node komputasi. Kegagalan satu node harus dapat ditangani secara otomatis tanpa mengulang pelatihan dari awal. Sistem harus sangat tangguh (fault-tolerant) dan mudah dikoordinasikan. 3. Efisiensi Biaya (FinOps) Menjalankan ribuan GPU/TPU secara terus-menerus adalah operasi yang sangat mahal. Infrastruktur harus dirancang untuk memanfaatkan sumber daya secara maksimal, sering kali melibatkan penggunaan instans spot (preemptible) di cloud untuk efisiensi biaya yang ekstrem. [Placeholder Gambar 1: Ilustrasi arsitektur data pipeline dari Object Storage ke cluster GPU](Alt Text: Diagram alur data saat Mendesain Infrastruktur ML Skala Petabyte) Pilar Infrastruktur ML Skala Petabyte Infrastruktur yang scalable bertumpu pada tiga pilar utama: Penyimpanan Data Terdistribusi, Sumber Daya Komputasi Paralel, dan Orkesstrasi yang Adaptif. Pilar 1: Penyimpanan Data Terdistribusi (Object Storage) Sistem penyimpanan tradisional tidak efektif pada skala PB karena masalah I/O throughput dan biaya. Solusinya adalah beralih ke Object Storage yang terdistribusi secara horizontal. Ini adalah langkah krusial dalam mendesain infrastruktur ML skala Petabyte. Karakteristik Implementasi Utama Scalability Amazon S3, Google Cloud Storage (GCS), Azure Blob Storage. Optimized Format Data harus disimpan dalam format yang optimal, seperti Apache Parquet, TFRecords, atau WebDataset, yang memungkinkan pembacaan kolom selektif dan prefetching yang cepat. Data Pipelining Menggunakan framework seperti Apache Spark untuk pra-pemrosesan data, memisahkan beban kerja I/O dari komputasi GPU. Pilar 2: Sumber Daya Komputasi Paralel (GPU/TPU Clusters) Pelatihan PB data hampir selalu memerlukan pelatihan terdistribusi. Infrastruktur komputasi harus mendukung klaster heterogen yang terdiri dari ratusan akselerator. Pilar 3: Orkesstrasi dan Manajemen Sumber Daya Kubernetes adalah fondasi utama orkestrasi. Diperlukan platform manajemen ML yang berjalan di atasnya: [Placeholder Gambar 2: Ilustrasi arsitektur klaster Kubernetes yang menjalankan Kubeflow](Alt Text: Visualisasi cluster GPU dengan Kubeflow untuk pelatihan ML terdistribusi) Strategi Desain Lanjutan untuk Skalabilitas Untuk mencapai skalabilitas Petabyte, desainer harus fokus pada bagaimana data dan komputasi diparalelkan, ini adalah tantangan inti dalam mendesain infrastruktur ML skala Petabyte. 1. Data Parallelism vs. Model Parallelism Pelatihan dengan data besar umumnya menggunakan Data Parallelism. Seluruh model disalin ke setiap node komputasi. Dataset dibagi menjadi minibatch yang didistribusikan. Gradien kemudian digabungkan menggunakan teknik komunikasi seperti All-Reduce (diimplementasikan oleh Horovod). 2. Penggunaan Memori Cerdas dan Zero-Copy Meminimalkan penyalinan data adalah kunci. Framework modern memanfaatkan Zero-Copy Networking untuk mentransfer data langsung dari buffer memori GPU ke GPU lain tanpa melalui CPU dan memori host. 3. Fault Tolerance dan Checkpointing Karena pelatihan memakan waktu lama, mekanisme checkpointing harus sangat andal dan sering dilakukan. MLOps dan Observabilitas Infrastruktur PB bersifat kompleks, sehingga MLOps (Machine Learning Operations) adalah keharusan. Untuk wawasan lebih lanjut mengenai pentingnya otomatisasi, baca artikel kami tentang [Peran Penting MLOps dalam Siklus Hidup Pengembangan Model]. [INTERNAL LINK] Observabilitas Menyeluruh Kesimpulan Mendesain infrastruktur ML skala Petabyte memerlukan pergeseran paradigma dari komputasi sentralistik ke sistem terdistribusi yang sangat paralel. Kunci keberhasilannya terletak pada pemilihan sistem Object Storage yang tepat, pemanfaatan akselerator yang didukung oleh jaringan low-latency, dan orkestrasi yang cerdas menggunakan MLOps. Infrastruktur ini tidak hanya menjamin model dapat di-training dengan data terbesar, tetapi juga menjamin efisiensi biaya dan kecepatan iterasi yang sangat kompetitif. Sumber: https://cloud.google.com/architecture/mlops-continuous-delivery-and-automation-pipelines-in-machine-learning